The latest report from the ECB suggests that widespread adoption of the digital euro is far from reality, as most Europeans still prefer conventional payment methods.

Chasing crypto wealth? Don’t let tax obligations drain your profits. We reveal the best ways to lower your tax expenses and keep more of your earnings.

What does a typical day look like for a Web3 founder? Pitching investors, managing internal crises, and trying to stay sane—this and much more in our deep dive.

Forget old-school luxury. Crypto millionaires are redefining status with ultra-rare NFTs, high-stakes blockchain investments, and exclusive crypto communities. The future of wealth is digital.

The crypto market is an extreme rollercoaster. Successful traders thrive by mastering key crypto trade habits: discipline, analysis, and filtering out the noise. Here’s what helps them stay ahead.

The latest report from the ECB suggests that widespread adoption of the digital euro is far from reality, as most Europeans still prefer conventional payment methods.

The recent $2 billion Binance investment from Abu Dhabi’s MGX marks the single largest investment into a crypto company.

Nebraska has tightened regulations on cryptocurrency ATMs. The new law mandates licensing, sets transaction limits, and requires operators to inform users about potential fraud risks.

Learn what a bullish market is, its key characteristics, and how to identify early signs before a full bull market develops. Gain insights into market trends and strategies.

Learn about Multi-Party Computation (MPC) in crypto, its mechanics, and benefits. Discover how MPC enhances security, privacy, and decentralized collaboration in digital transactions.

Discover top strategies to profit in the crypto market—from HODLing and trading to staking, yield farming, NFTs, and crypto lending. Learn the risks and rewards for beginners.

Trump’s meme coin isn’t an outlier—it’s part of a broader trend. Back in 2021, celebrities were minting NFTs, and by 2024, they had moved on to personal token launches. The connection between fame and crypto has been growing for years, even if many failed to see it.

Across continents, monuments have been erected to honor both cryptocurrencies and the figures who transformed the digital finance world. We explore the most well-known of these in our article.

Wow, what a rollercoaster of a year! Especially for crypto fans and even more so for Bitcoin holders and all those who have waited for the mother-of-all-crypto to cross its second major mark after the $50 thousand level, the $100 thousand level.

In the chaotic world of cryptocurrencies, no platform captures the spirit of financial anarchy better than Pump.fun. What began as an experiment on Solana in early 2024 soon turned into a meme coin explosion.

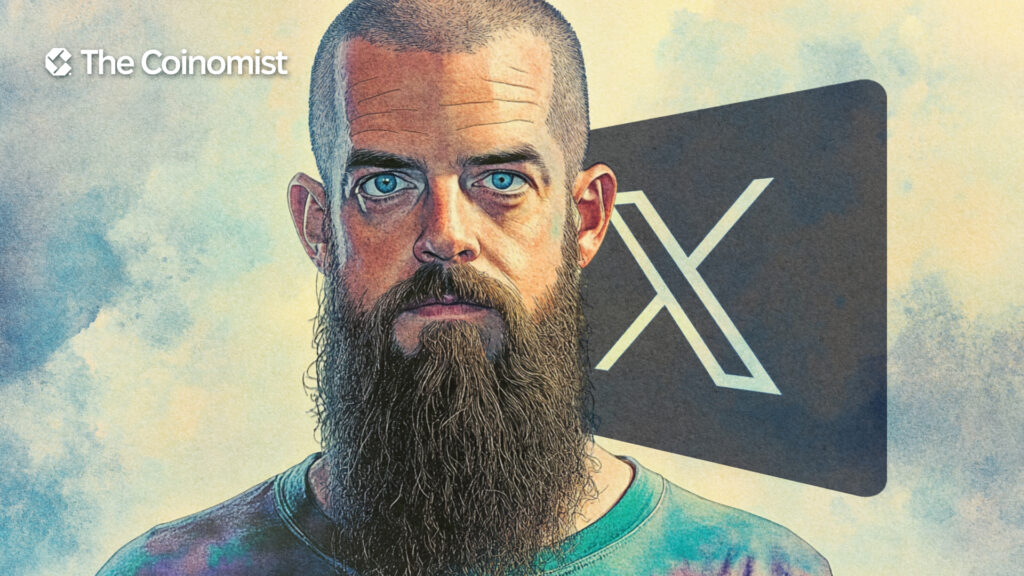

A common topic on crypto Twitter (X) today is: ‘Why was Jack Dorsey suspended on the platform he created?' This leads to another question about the decentralization and control of social media.

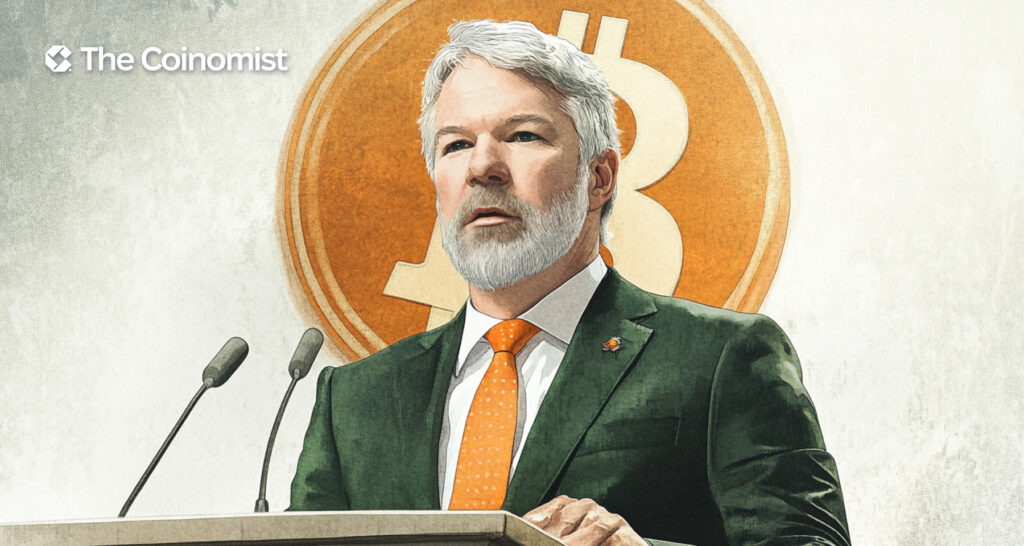

Crypto moving forward despite market ups and downs. Michael Saylor's speech on Bitcoin, the launch of Bubblemap’s BMT token, and the growth of stablecoins have been drawing a lot of attention.

Crypto is unforgiving—one mistake, and even the biggest players can fall. Some collapsed under regulatory crackdowns; others were undone by internal crises. But Binance regulation stands apart, proving it’s built for survival.

It takes just one post from Trump to stir the crypto market. Recently, he announced on Truth Social that the evaluation of a strategic crypto reserve is in progress as part of his broader Trump crypto policy.

There's been a lot of talk about possible changes to crypto tax policies in the U.S. One of the more controversial ideas floating around is “Trump no tax on crypto.” As Trump adopts a more crypto-friendly stance, major rumors have surfaced that he’s considering a 0% tax on crypto gains.

2025 isn’t exactly the most stable time for the economy: policy changes, trade tariffs, international tensions, and interest rate shifts are among the factors that make things more unpredictable. In times like these, people naturally start looking for alternatives, and one of the biggest ones has been crypto.

Matvii Diadkov, founder of Bitmedia, shared with us in an exclusive interview his expert insights on Web3 adoption, impact of GameFi and community-centering tendencies in the market.

The first crypto craze took place almost a decade ago. Overnight, many people found out about Bitcoin and its underlying technology, blockchain.

Volodymyr Nosov, CEO of Europe’s largest crypto exchange WhiteBIT, sat down with Dmytro Gordon, one of Ukraine’s most prominent journalists. The interview touched on Bitcoin, crypto, WhiteBIT, cars, keys to success, and business vision.

Learn what a bullish market is, its key characteristics, and how to identify early signs before a full bull market develops. Gain insights into market trends and strategies.

Singapore, one of the world's most advanced economies and a leading IT hub in Asia alongside Shanghai and Hong Kong, hosted this year's largest crypto conference, Token2049.

Are sky-high Ethereum fees getting you down? The folks at Zora have come up with an alternative, introducing their Layer 2 solution with lower transaction fees. This article will walk you through how to get involved with the project and earn some rewards.